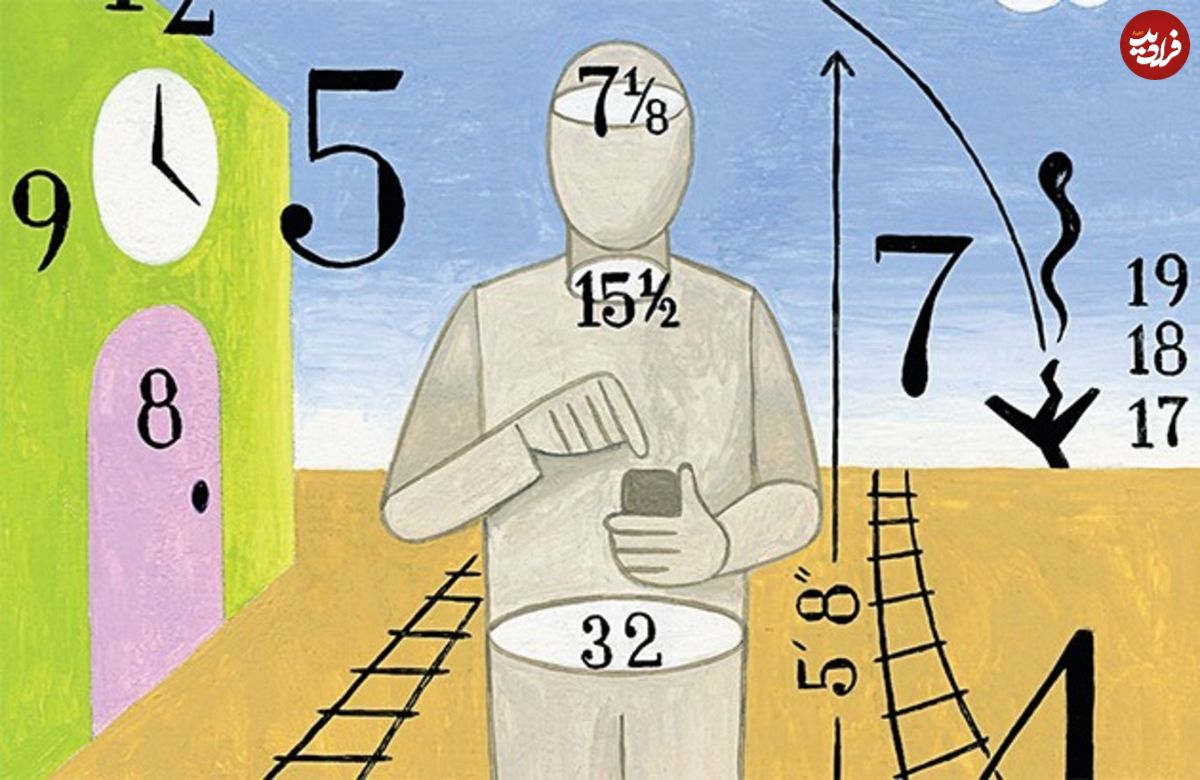

اعداد همیشه راست میگویند، مگر وقتی که دروغ میگویند

اعداد جذاباند. چه از این بهتر که پدیدهای پیچیده را در قالب چند عدد و رقم ساده و قابلفهم برای همه توضیح بدهیم؟ مهم نیست پیشبینی انتخابات باشد، اندازهگیری تورم، تاثیرگذاری واکسیناسیون، یا سنجش هوش؛ همه را میتوان در چند رقم خلاصه کرد. اما کاش همهچیز به همین سادگی بود. وقتی بخواهیم دنیا و پیچیدگیهایش را در قالب اعداد جای دهیم، باید بخش زیادی از جزئیات را دور بریزیم، جزئیاتی که گاهی اصل داستاناند؛ و ماجرا تازه از اینجا آغاز میشود.

نیویورکر، هانا فرای | تونی بلر معمولاً در مقابل جمعیت آرامش و چهرۀ کاریزماتیکش را حفظ میکرد. اما در آوریل ۲۰۰۵ بهوضوح میشد دید که مواجهه با یک خانم از یکی از استودیوهای تلویزیونی لندن او را بهکلی به هم ریخته است. بلر، در دوران هشتسالۀ تصدی پست نخستوزیری بریتانیا، مأموریت داشت تا سطح خدمات بهداشت عمومی را ارتقا دهد. خدمات بهداشت عمومی (ان. اچ. اس) یکی از محبوبترین سازمانها در کل بریتانیا است که درعینحال بیش از همه تمسخر میشود و مغفولماندهترین سازمان نیز است، سازمانی که ویژگیهای منحصربهفرد و ناکارآمدیهای خاص خود را دارد.

در آن زمان، صدای همه درآمده بود از اینکه نمیشد، در بازۀ زمانی قابلِقبول، از دکترها وقت گرفت؛ غالباً به بیماران گفته میشد که باید برای اولین وقتِ خالی چند هفته منتظر بمانند. دولت بلر، که محل اجتماع فنسالارهای کاردُرست بود، تصمیم گرفت برای حل این مشکل هدفی تعیین کند: برای دکترهایی که حداکثر طی ۴۸ ساعت از زمان درخواست بیمار را به حضور بپذیرند مشوقهای مالی در نظر گرفته خواهد شد.

این برنامه به نظر منطقی میآمد. اما آن روز حضار از مشکلی باخبر بودند که از چشم بلر و دولتش مخفی مانده بود. درحالیکه مصاحبه بهصورت زنده از تلویزیون پخش میشد، دایانا چِرچ با خونسردی برای نخستوزیر توضیح داد که دکترِ پسرش خواسته در یکی از روزهای هفتۀ آینده آنها را ببیند و بااینحال درمانگاه به آنها گفته است که حداکثر میتواند ۴۸ ساعت زودتر از زمان ملاقات درخواست آنها را ثبت کند. چون درغیراینصورت پزشکانِ آنجا از آن پاداش محروم میمانند. چنانچه چِرچ میخواست از دکتر پسرش برای هفتۀ آینده وقت بگیرد، مجبور بود تا روز قبلش صبر کند و سپس ساعت ۸ صبح تماس بگیرد و مدتها پشت خط منتظر بماند. تا پیش از برقراری تشویقها، دکترها نمیتوانستند از یک حدی زودتر وقت بدهند؛ بعد از آن، دلشان نمیخواست از یک حدی دیرتر وقت بدهند.

مجری پرسید: «شما خبر نداشتید؟».

بلر پاسخ داد: «من خبر نداشتم».

مجری رو کرد به حضار و پرسید: «کس دیگری هم این تجربه را داشته است؟».

آشوبی به پا شد. اعتراضها بالا گرفت، بلر به تِتِهپِتِه افتاد و یک ملت دیدند که چگونه رهبرشان، بهخاطر مشکل رایجی به نام جوردرنیامدن حسابوکتابها، کنترلش را از دست داد.

بلر و مشاورانش اولین کسانی نبودند که در اهدافشان حسننیت دارند، اما بهواسطۀ همان اهداف به دردسر میافتند. هرگاه تلاش کنید دنیای واقعی را مجبور به انجام کاری کنید که با عدد و رقم قابلاندازهگیری است، با پیامدهای ناخواستۀ زیادی مواجه خواهید شد. دو کتاب جدید در حوزۀ دادهها و آمار به همین موضوع میپردازند: حسابکردن۱: چگونه از اعداد برای تعیین اهمیت استفاده میکنیم (انتشارات لایورایت)، نوشتۀ دبورا استون، که ما را از خطرات ناشی از تکیۀ بیشازحد به اعداد آگاه میکند، و کتاب کارآگاهِ دادهها (انتشارات ریورهِد)، نوشتۀ تیم هارفورد، که روشهایی را نشانمان میدهد برای اجتناب از تلههای موجود در دنیایی که بر مبنای دادهها مدیریت میشود.

هر دو کتاب زمانی منتشر شدهاند که قدرت خارقالعادۀ دادهها هیچگاه به این اندازه مشهود نبوده است. همهگیری کووید ۱۹ نشان داد که، بدون داشتن آمار مناسب، جهان تا چه حد میتواند آسیبپذیر باشد. همچنین، با فرارسیدن انتخابات ریاستجمهوری، روزنامهها پر شد از نظرسنجیها و پیشبینیها دربارۀ نتایج انتخابات که هدف همۀ آنها فرونشاندن عطش ما برای سردرآوردن از شرایط بود. در این یک سالی که در شرایط عدم قطعیت گذشت، اعداد و ارقام برایمان حکم منبع آرامش را داشت. ما فریب دقت ظاهری و عینیت دادهها را میخوریم و وقتی آمار و ارقام نمیتوانند سرکشیهای واقعیت را به بند بکشند، گاه احساس میکنیم به ما خیانت شده است.

اشتباهی که تونی بلر و تیم خبرۀ سیاستگذاریاش انجام دادند آنقدر اشتباه رایجی است که حکم ضربالمثل را پیدا کرده است: وقتی یک عددِ مفید به معیاری برای اندازهگیری موفقیت تبدیل شود، مفیدبودنش را از دست خواهد داد. این موضوع به قانون گودهارت۲معروف است. این قانون به ما یادآوری میکند که اندازهگیریِ دنیای انسانها میتواند جهت حرکت آن را تغییر دهد. دبورا استون در کتابش مینویسد که در شوروی برای کارخانهها و مزارع سهمیۀ تولید تعیین میشد، بهنحوی که شغل و معاش مردم در گرو تحقق این سهمیهها بود. کارخانههای نساجی ملزم میشدند که مقدار معینی پارچه تولید کنند که این مقدار بر اساس طولْ مشخص میشد و درنتیجه بسیاری از دستگاههای پارچهبافی بهنحوی تنظیم میشدند که نوارهای پارچهای طولانی، اما باریک تولید کنند.

عملکرد پنبهچینهای ازبک بر اساس وزن محصولِ برداشتشده سنجیده میشد؛ بنابراین آنها پنبه را در آب میخیساندند تا سنگینتر شود. به همین شکل، وقتی در دهۀ ۱۸۶۰ اولین راهآهن سراسری در آمریکا ساخته میشد، حقالزحمۀ پیمانکارها برحسب مایل تعیین میشد. بنابراین، بخشی از راهآهن در اطراف اوماها و نبراسکا، بهجای اینکه بهصورت خط مستقیم کشیده شود، بهشکل یک قوس بزرگ ساخته شد که باعث شد چندین مایل مسیر غیرضروری (اما سودآور) به خط آهن اضافه شود. مشکل زمانی ایجاد میشود که ما، برای چیزهایی که به آن اهمیت میدهیم، جایگزینهای عددی۳ تعیین میکنیم. استون در کتابش جملهای را از قول اقتصاددان محیطزیست، جیمز گوستاو اسپت، نقل میکند: «ما تمایل داریم آنچه را اندازه میگیریم به دست آوریم، پس میباید چیزهایی را اندازه بگیریم که مطلوبمان باشد».

البته این مشکل به این سادگیها حل نمیشود. مشکلاتی که پیرامون قانون گودهارت وجود دارد گریبان طراحیهای هوش مصنوعی را هم خواهد گرفت: چطور میخواهید هدفی را برای الگوریتمتان توضیح دهید وقتی اعدادْ تنها زبان مشترک بین او و شما هستند؟ دانشمند علوم رایانه، رابرت فِلت، یک بار الگوریتمی طراحی کرد که وظیفۀ فرودآوردن هواپیما بر روی ناو هواپیمابر را برعهده داشت. هدف این بود که یک هواپیمای شبیهسازیشده را بهآرامی بنشاند، طوری که کمترین فشار ممکن به بدنۀ هواپیما وارد شود. متأسفانه، در حین اجرای تمرینی، مشکلی در الگوریتم شناسایی شد.

اگر الگوریتم، بهجای اینکه هواپیمای شبیهسازیشده را خیلی نرم فرود بیاورد، ناگهان بکوبد روی ترمز، نیروی واردشده به هواپیما از توان سیستم فراتر رفته و دقیقاً معادل صفر در سیستم ثبت خواهد شد. فِلت متوجه شد که الگوریتم او در اجرای آزمایش بالاترین نمره را در آزمون کسب میکند درحالیکه در واقعیت میتوانست هواپیماها را با خاک یکسان کند.

خطرناکترین نوع استفاده از دادهها زمانی رخ میدهد که از آنها برای کنترلِ چیزها استفاده کنیم نه برای فهمیدن آنها. قانون گودهارت درواقع نشاندهندۀ محدودیت اساسیتری در نگاه دادهمحور به جهان است. به نوشتۀ تیم هارفورد، دادهها «میتوانند جایگزین کاملاً قابلِاحترامی باشند برای چیزهایی که برایمان مهماند»، اما حتی بهترین جایگزینها نیز با اصلِ خود فاصلۀ بسیاری دارند، فاصلهای میان آن چیزی که قادر به اندازهگیری آن هستیم و آن چیزی که واقعاً برایمان مهم است.

هارفورد از روانشناس برجسته، دنیل کانمن، نقل میکند که در کتابش، تفکر سریع و آهسته، توضیح داده است که وقتی ما با سؤال دشواری مواجه میشویم عادت داریم آن را با یک سؤال ساده عوض کنیم و معمولاً هم این کار را ناخودآگاه انجام میدهیم. مصداقهایی از این موضوع را میتوان در سؤالهایی مشاهده کرد که جامعه تلاش میکند با استفاده از دادهها به آنها پاسخ دهد. یکی از مثالهای بارزش مدرسه است. ممکن است دغدغۀ این را داشته باشیم که آیا بچههایمان آموزش مناسبی در مدرسه دریافت میکنند یا نه. اما مشکل اینجاست که دقیقاً نمیتوانیم مشخص کنیم که منظورمان از «مناسب» چیست.

درعوض، به یک سؤال مرتبط و البته سادهتر متوسل میشویم: اینکه دانشآموزمان در آزمونی خاص، که تنها از بخشی از پیکرۀ واقعیت گرفته میشود، چه عملکردی دارد؟ و بهاینترتیب گرفتار سندروم رقتانگیز «آموزش برای آزمون» ۴ میشویم. مثال دیگری از این موضوع استفاده از شاخص تولید ناخالص داخلی (جی دیپی) برای تعیین وضعیت اقتصادی یک کشور است. بر طبق این شاخص، اگر یک معلم مدرسه به یکی از شاگردانش تعرض کند و به همین دلیل به یک زندان فوق امنیتی منتقل شود، نسبت به حالتی که به آن دانش آموز درس یاد بدهد، مشارکت بیشتری در موفقیت اقتصادی کشورش خواهد داشت چون، بهواسطۀ زندانرفتن آن معلم، کلی شغل ایجاد میشود.

یکی از بحثبرانگیزترین کاربردهای الگوریتمها در سالهای اخیر پیشنهاد آزادی برای زندانیانی است که در انتظار جلسۀ دادگاه هستند. در دادگاههای سراسر آمریکا، وقتی کسی به جرمی متهم میشود، یک الگوریتمْ سوابق مجرمیت او را بررسی میکند و عددی را بهعنوان نمرۀ ریسک آن فرد استخراج میکند تا قاضی به کمک آن عدد تصمیم بگیرد که آن فرد، تا فرارسیدن زمان دادگاه، باید پشت میلهها باشد یا خیر. الگوریتم، با استفاده از دادههای مربوط به اتهامهای قبلیِ فرد، تلاش میکند تا احتمال ارتکاب مجدد جرم را برای آن فرد محاسبه نماید. اما در اینجا هم، بین چیزی که برایمان مهم است و چیزی که میتوانیم آن را اندازه بگیریم، یکی از آن تعویضهای ظریفِ کانمنی انجام میشود. الگوریتم نمیتواند پیشبینی کند که چه کسی قرار است دوباره مرتکب جرم شود. بلکه تنها میتواند پیشبینی کند که چه کسی دوباره دستگیر خواهد شد.

البته که نرخ دستگیرشدن برای همۀ افراد یکسان نیست. برای مثال سیاهپوستان و سفیدپوستان در آمریکا، هر دو، تقریباً به یک اندازه از ماریجوانا استفاده میکنند، اما گروه اول تقریباً چهار برابر گروه دوم احتمال دارد بهخاطر حمل ماریجوانا دستگیر شوند. الگوریتمی که بر اساس دادههای دارای سوگیری ساخته شده باشد منجر به تداوم رفتارهای دارای سوگیری خواهد شد (برایان کریستین در کتاب اخیرش، مسئلۀ همراستایی۵، ۶، مسائل بغرنجی از این دست را به شکلی عالی از نظر گذرانده است). این به این معنی نیست که قضاوت انسانی لزوماً عملکرد بهتری خواهد داشت، اما بههرحال سوگیریِ ورودی سوگیریِ خروجی را به دنبال خواهد داشت و این مشکل میتواند ارزش این نوع پیشنهادهای درخشان و دادهمحور را تا حد زیادی با محدودیت همراه کند.

کافی است سؤالی را در یک پرسشنامه تغییر دهید، ولو تغییر جزئی، و ببینید که چگونه همهچیز تغییر خواهد کرد. حدود ۲۵ سال پیش در اوگاندا، آمار نیروی کار فعال بهطور ناگهانی بیش از ۱۰ درصد افزایش یافت و از ۶.۵میلیون نفر به ۷.۲میلیون نفر رسید. طبق توضیح هارفورد، این افزایش ناشی از تغییر در کلمات پرسشنامۀ نیروی کار بود. تا پیش از آن، از مردم خواسته میشد تا فعالیت یا شغل اصلیشان را اعلام کنند، اما در نسخۀ جدید پرسشنامه از افراد خواسته میشد تا نقشهای ثانویهای که بر عهده دارند را نیز ذکر کنند. بهاینترتیب، ناگهان صدها هزار زن اوگاندایی، که شغل اصلیشان خانهداری بود، اما ساعتهای زیادی را هم به انجام کارهای دیگر میگذراندند، به آمار کلی اضافه شدند.

برای اینکه بتوانیم دنیا را در قالب اعداد درآوریم، باید آن را تا حد نیاز کوچک کنیم و این یعنی دورریختن حجم زیادی از جزئیات. این حذفکردنهای اجتنابناپذیر میتواند دادهها را، برای گروههای خاصی از افراد، با سوگیری همراه کند. استون توضیح میدهد که سازمان ملل متحد زمانی تلاش کرد دستورالعملهایی را برای اندازهگیری سطح خشونت علیه زنان تدوین کند. نمایندگانی از اروپا، آمریکای شمالی، استرالیا و نیوزلند نظراتشان را دربارۀ نوع خشونتهایی که باید در این دستورالعملها گنجانده شود مطرح کردند.

نظرات آنها بر مبنای تحقیقاتِ پیمایشیای بود که بر روی قربانیان در کشورهای خودشان انجام شده بود. موارد پیشنهادی عبارت بودند از مشتزدن، لگدزدن، گازگرفتن، سیلیزدن، هُلدادن، کتککاری و فشردن گلو. در همین حین، تعدادی از زنان بنگلادشی پیشنهاد دادند که اَشکال دیگری از خشونت نیز باید لحاظ شود -اعمالی که در شبهقارۀ هند خیلی هم غیرمعمول نیستند- کارهایی مثل سوزاندن زنان، اسیدپاشی بر روی آنها، پرتابکردن آنها از ارتفاع و مجبورکردن آنها به خوابیدن در آغل حیوانات. هیچکدام از این موارد در فهرست نهایی گنجانده نشد. بنابراین، وقتی یک تحقیق پیمایشی بر اساس دستورالعملهای سازمان ملل متحد انجام شود، یافتههای اندکی دربارۀ زنانی به دست خواهد آمد که در معرض این نوع از خشونتها قرار دارند. به قول استون، قبل از شمردن، ابتدا باید تصمیم بگیریم که چه چیزهایی باید شمرده شوند.

کسی که کارِ شمارش را انجام میدهد قدرت دارد. دیدگاههای ما تأثیر عمیقی دارد در تعیین اینکه چه چیزی ارزش شمردهشدن دارد. درنتیجه، هرقدر هم در فرایند جمعآوری دادهها حسننیت داشته باشیم، باز هم چیزهایی را از قلم خواهیم انداخت. متأسفانه گاهی نیز سوگیریها عمداً از نظرها پنهان نگاه داشته میشود. در سال ۲۰۲۰، در مجلۀ سایکولوجیکال ساینس، مقالهای چاپ شد که رابطۀ بین بهرۀ هوشی و تعدادی از شاخصهای اقتصادیاجتماعی را در کشورهای مختلف جهان بررسی کرده بود. متأسفانه، این مقاله به دادههای ملی مربوط به تخمین بهرۀ هوشی استناد کرده بود، گزارشی که با همکاری روانشناس بریتانیایی، ریچارد لین، منتشر شده است. ریچارد لین علناً معتقد به برتری سفیدپوستان است. هرچند که قاعدتاً باید بتوانیم مشارکت علمی لین در آن پژوهش را مستقل از دیدگاههای شخصیاش ارزیابی کنیم، اما مجموعه دادههایی که او برای تخمین بهرۀ هوشی استفاده کرده است در برخی مواقع شامل نمونههای آماری مشکوکی است که نمیتواند بهخوبی معرف جامعۀ غیراروپایی باشد. مثلاً تخمین او از بهرۀ هوشی جامعۀ سومالی بر مبنای نمونۀ آماری کودکانی است که در یکی از اردوگاههای پناهندگان

در کنیا اقامت داشتند.

تخمین بهرۀ هوشی مردم هائیتی بر اساس یک نمونۀ آماری شامل ۱۳۳ کودک ششسالۀ روستایی تعیین شده است. تخمین بهرۀ هوشی مردم بتسوانا هم بر مبنای یک نمونۀ آماری از دانشآموزان دبیرسانی محاسبه شده است و آزمون آنها هم در آفریقای جنوبی و با زبانی غیر از زبان مادریشان اجرا شده است. بعد از آن، روانشناسی به نام یِلته ویکرتس نشان داد که بهترین عاملی که میتواند حضور یک نمونۀ آماری از یک کشور آفریقایی را در پژوهش لین پیشبینی کند این است که میانگین بهرۀ هوشی در آن نمونه از میانگین جهانی پایینتر باشد. درنتیجه، سایکولوجیکال ساینس این مقاله را حذف کرد، اما همچنان مقالهها و کتابهای فراوانی هستند که به دادههای لین استناد کردهاند.

البته، بهرۀ هوشی هم گرفتار همان مشکلات آشنایی است که در استفاده از متغیرهای آماریِ جایگزین با آن مواجهیم؛ بهرۀ هوشی عددی است که در کاری مثل اندازهگیریِ قطعی، مطلق و تغییرناپذیرِ «هوش» بهطرز ناامیدکنندهای شکست میخورد. البته وجود چنین محدودیتهایی به این معنی نیست که بهرۀ هوشی کاملاً بیارزش است. بهرۀ هوشی، در بسیاری موارد، قدرت پیشبینی بالایی دارد: درآمد، طول عمر و موفقیت حرفهای. متغیرهای جایگزین همچنان میتوانند بهعنوان شاخصی که چیزی را اندازه میگیرد به کارمان بیایند، حتی اگر بهراحتی نتوانیم تعیین کنیم که آن چیز چیست.

شمردنِ همهچیز غیرممکن است؛ پس مجبوریم جایی را بهعنوان خط مرزی مشخص کنیم. اما وقتی مفاهیمی که با آن سروکار داریم مبهمتر از مفاهیمی، چون زمان لازم برای وقتگرفتن از دکتر یا طول مسیر راهآهن هستند، خودِ عمل مرزکشی میتواند مشکلساز شود. هارفورد، در ادامه، مثال دو گوسفند در یک مزرعه را میزند: «در یک مزرعه دو گوسفند داریم، اما نکته اینجاست که یکی از گوسفندها درواقع گوسفند نیست بلکه بره است. گوسفند دیگر هم در مرحلۀ آخر بارداری است.

درواقع در آستانۀ وضع حمل است و هر لحظه ممکن است زایمان کند. حالا بگویید چند گوسفند داریم؟». سؤالهایی از این دست فراتر از یک آزمایش ذهنی ساده هستند. یکی از دوستانم به نام سوزی گِیج، که نویسنده و روانشناس است، در دوران همهگیری کووید ۱۹ با شوهرش ازدواج کرد. او آنموقع در هفتۀ سیونهم بارداریاش بود. به دلیل محدودیتهایی که در آن زمان وضع شده بود نمیتوانستند بیشتر از ۱۰ نفر را به مراسم عروسیشان دعوت کنند. نوزادها گاهی جزء آمار حساب میشوند. پس اگر بچۀ آنها قبل از روز عروسی به دنیا میآمد، او و آقای داماد یا باید قید دعوت از یکی از اعضای نزدیک خانواده را میزدند یا اینکه بچۀ تازهمتولدشده را در خانه تنها میگذاشتند.

همیشه نمیتوان دنیا را در چند دستهبندیِ ساده جای داد. گاهی اوقات مجبوریم تصمیمات سختی بگیریم دربارۀ اینکه اولاً چه چیزی را باید به حساب آورد و ثانیاً اینکه چطور باید مقدار آن چیز را محاسبه کرد. بنابراین، به دنبال روش آزمایشگاهیِ کاملاً کنترلشدهای میگردیم که تمام دادهها در آن مشخص و حسابشده باشد. آرزویمان هم این است که در انتهای آزمایش به توصیف کاملاً دقیقی از واقعیت دست پیدا کنیم. البته ممکن است آکواریومی در آلمان تمام این آرزو را نقش بر آب کند.

مارمورکرِب نوعی خرچنگ است، شبیه انواع دیگر خرچنگها -با پاهای باریک و بدن خالدار-، اما در پشت این ظاهر مشابه یک تفاوت استثنایی پنهان شده است: مارمورکرِبها بهشیوۀ غیرجنسی تولیدِمثل میکنند. یک مارمورکرِب از نظر ژنتیکی کاملاً شبیه فرزندانش است.

مایکل بلستلند، در کتاب نیمۀ پنهان: جهان چگونه اسرارش را مخفی میکند۷ (انتشارات آتلانتیک بوکز)، توضیح میدهد که وقتی دانشمندان برای اولین بار این موجود عجیب را کشف کردند آن را فرصتی دانستند برای پاسخ به بحث قدیمیِ طبیعت (ژنتیک) یا تربیت (محیط). آنها یک گروه کنترل ایدئال برای آزمایششان پیدا کرده بودند. همۀ کاری که برای شروع باید انجام میدادند این بود که لشکر کوچکی از مارمورکرِبهای نوجوان، که همگی از نظر ژنتیکی با هم یکسان بودند، را جمعآوری کنند و آنها را در محیطی یکسان پرورش دهند -به همۀ آنها مقدار یکسانی آب با دمای یکسان، مقدار یکسانی غذا و مقدار یکسانی نور بدهند- و منتظر بمانند تا همۀ آنها به موجودات بالغ کاملاً یکسانی تبدیل شوند. بعد از آن، دانشمندان میتوانستند متغیرهای محیطی را دستکاری کنند و به بررسی نتایج بپردازند.

بااینحال، همینطور که این مارمورکرِبهای یکسان در شرایط محیطی یکسان رشد میکردند، تفاوتهای قابلِتوجهی در آنها پدیدار میشد. تفاوت چشمگیری در اندازۀ آنها دیده میشد بهطوری که وزن یکی از آنها ۲۰ برابر دیگری شده بود. رفتارشان هم با هم فرق میکرد: بعضی از آنها پرخاشگرتر از دیگران بودند، بعضیها تنهایی را ترجیح میدادند. بعضیها دوبرابر خواهر و برادرهایشان عمر میکردند. الگوی خالهای روی پوستۀ هیچ دو مارمورکرِبی شبیه هم نبود؛ حتی شکل اندامهای داخلی آنها نیز با هم متفاوت بود.

دانشمندان، برای ثابت نگهداشتن تکتک نقاط دادهای، نهایت تلاششان را به خرج داده بودند؛ آنها تلاش طاقتفرسایی را برای ثبت و کنترل هرآنچه قابلِاندازهگیری بود انجام داده بودند. بااینحال، گیج شده بودند از دیدن اینهمه تفاوتهایی که برایشان نه قابلِتبیین بود و نه قابلِپیشبینی. حتی کوچکترین نوساناتی، که از چشمان علم مخفی میمانَد، میتواند با گذشت زمان تشدید شده و دنیایی از تفاوت را ایجاد کند. سرشت بر اساس ویژگیهای تصادفیِ اجتنابناپذیری بنا میشود و بهاینترتیب نگاهِ دادهمحور به واقعیت را با محدودیت مواجه میکند.

حوالی سال ۲۰۰۰، گروهی از پژوهشگران شروع کردند به دعوت از افراد برای شرکت در پژوهشی که نامش را گذاشته بودند «خانوادههای شکننده». پژوهشگران دنبال خانوادههایی با نوزادان تازهمتولدشده میگشتند تا پیشرفت فرزندان و والدین آنها را برای چندین سال ردگیری کنند. آنها بیش از چهارهزار خانواده را ثبتِنام کردند و، بعد از یک ملاقات اولیه، پژوهشگران خانوادهها را در مقاطع زمانیای که فرزندانشان یک، سه، پنج، نُه و پانزدهساله بودند دوباره ملاقات کردند.

در هر ملاقات، آنها دادههای مربوط به رشد کودکان، وضعیت خانواده و محیط زندگیشان را جمعآوری میکردند. آنها جزئیات مربوط به سلامتی، اطلاعات جمعیتشناختی، رابطۀ پدر و مادر، نوع محلهای که کودک در آن زندگی میکند و اینکه شبها چه ساعتی میخوابد را ثبت میکردند. محققان، تا انتهای پژوهش، نزدیک به ۱۳هزار داده را دربارۀ هر کودک جمعآوری کردند.

تیم پژوهش، در ادامه، کار نسبتاً هوشمندانهای انجام دادند. آنها، بهجای اینکه تمام دادهها را بهیکباره منتشر کنند، بخشی از دادههای مربوط به اواخر پژوهش را پیش خودشان نگه داشتند و از پژوهشگران سراسر دنیا دعوت کردند تا ببینند آیا آنها میتوانند یافتههای خاصی از پژوهش را پیشبینی کنند یا خیر. میخواستند ببینند که آیا پیچیدهترین الگوریتمهای یادگیری ماشینی و مدلهای ریاضیِ موجود در جهان میتوانند، با استفاده از تمام دانستههای مربوط به کودکان تا یک سنِ خاص، از وضعیت زندگی کودکان در سن پانزدهسالگی پرده بردارند یا خیر؟

برای اینکه چالش متمرکزتر شود، از پژوهشگران خواسته شد تا مقدار شش شاخص کلیدی را پیشبینی کنند، شاخصهایی مثل عملکرد تحصیلی بچهها در پانزدهسالگی. تیم پژوهش، برای اینکه یک خط مبنای واحد را برای همۀ آن پژوهشگران فراهم کند، مدل سادهای را برای پیشبینی در اختیار آنها قرار داد. مدلی که از شدتِ سادگی خندهدار بود. این مدل فقط از چهار نوع داده استفاده میکرد که سه مورد از آنها در زمان تولد کودک ثبت شده بود: سطح تحصیلات، وضعیت تأهل و نژاد مادر.

همانطور که حدس میزنید، آن مدلِ پایه حرف زیادی برای پیشبینی آینده نداشت. این مدل، در بهترین حوزۀ عملکردش، تنها میتوانست حدود ۲۰ درصد از واریانس دادهها را تبیین کند. اما از آن جالبتر عملکرد الگوریتمهای پیچیده بود. مدلهایی که بر اساس مجموعهای کامل و بسیار غنی از دادهها ساخته شده بودند، در بهترین حالت، تنها توانستند عملکرد مدلِ پایه را در حد چند درصدِ ناقابل بهبود ببخشند.

همچنین هیچکدام از مدلهای پیچیده نتوانست، در چهار حوزه از شش حوزه، از دقتِ ششدرصدیِ مدلِ پایه فراتر برود. حتی کارآمدترین الگوریتم هم تنها توانست ۲۳ درصد از واریانس موجود در میانگین نمرات بچهها را پیشبینی کند. درواقع، در تمام موارد، فاصلۀ بین عملکرد بهترین و بدترین مدلها همیشه کمتر بود از فاصلۀ بین بهترین مدلها و آنچه در واقعیت اتفاق افتاده بود. معنی این حرف، همانطور که تیم پژوهش هم اعلام کرد، این است که این مدلها «در پیشبینیکردن یکدیگر بهتر عمل میکنند» تا در پیشبینی مسیر زندگی یک انسان.

این به این معنی نیست که این مدلها بد هستند، بلکه آنها، بهشکل معناداری، بهتر از پیشبینی غریزی و پیشبینی بر اساس حدس و گمان عمل میکنند؛ از دهۀ ۱۹۵۰ به این سو، فهمیدهایم که حتی سادهترین الگوریتمها هم عملکرد بهتری از پیشبینیهای انسانی دارند. اما چالش «خانوادههای شکننده» حواسش بود که گرفتار این وسوسۀ رایج نشود که باور کند تمام جوابها در آستین اعداد و ارقام است. این واقعیت که مدلهای پیچیده، فقط میتوانند به مقدار ناچیزی مدلهای ساده را بهبود ببخشند ما را به همان سؤال آشنا میرساند، یعنی اینکه اولاً چه چیزی را باید به حساب آورد و ثانیاً اینکه چطور باید مقدار آن چیز را محاسبه کرد.

شاید بتوان نتیجۀ دیگری هم از این موضوع گرفت. هروقت که نظرسنجیها در پیشبینی نتایج انتخابات ناموفق عمل میکنند، معمولاً میشنویم که به دادههای بیشتر و بهتری نیاز است. اما حالا که فهمیدیم بیشترکردن دادهها همیشه جواب نمیدهد، شاید لازم باشد، بهجای این کار، در رابطۀ خودمان با پیشبینیکردن تجدیدنظر کنیم، یعنی بپذیریم که توانمندیِ اعداد و ارقام هم با محدودیتهای اجتنابناپذیری همراه است و، از آن به بعد، دیگر از مدلهای ریاضی توقع بیجا نداشته باشیم که بهخودیِ خود بتوانند ما را از ورطۀ عدم قطعیت بهسلامت عبور دهند.

اعداد جایگزین ناکارآمدی برای رنگ و غنای دنیای واقعی هستند. ممکن است تعجب کنید از اینکه میبینید یک ریاضیدان حرفهای (مثل من) یا یک اقتصاددان حرفهای (مثل هارفورد) دارند تلاش میکنند تا شما را نسبت به این حقیقت مجاب کنند. اما درک محدودیتهای موجود در نگاهِ دادهمحور به جهان به معنای کمرنگ جلوهدادن تواناییهای آن نیست. دو گزارۀ ذیل میتواند همزمان برقرار باشد: اعداد و ارقام در برابر ظرافتهای موجود در واقعیت کم میآورند و، درعینحال، وقتی پای فهمیدن همان واقعیت در میان باشد، اعداد و ارقام قدرتمندترین ابزاری هستند که در اختیار داریم.

آنچه در همهگیری کووید ۱۹ اتفاق افتاد حقیقت قاطعی را به تصویر کشید. اینکه میزان واقعی خسارتهای ناشی از این ویروس در آمار و ارقام نمیگنجد. وقتی قرار است بگوییم کارکردن در بخش مراقبتهای ویژه یعنی چه، یا اینکه ازدستدادن عزیزی بر اثر این بیماری چه حسی دارد آمار و ارقام حرفی برای گفتن ندارد. آمار و ارقام حتی در شمارش تعداد واقعی جانهایی که در این میان از بین رفتهاند هم ناتوان است (منظورم آمار مرگهایی نیست که با یک دستهبندی شستهرفته شمرده میشود، مثل آمار مرگهایی که طی ۲۸ روز بعد از مثبتشدن آزمایش اتفاق میافتد). آمار و ارقام نمیتواند با قطعیت بگوید که چهوقت به شرایط عادی باز خواهیم گشت. اما، درعینحال، آمار و ارقام تنها ابزاری است که در دست داریم تا با آن میزان کشندهبودن این ویروس را درک کنیم، از نحوۀ کارش سر در بیاوریم و، هرچند غیرقطعی، بتوانیم آیندههای محتملی که در انتظارمان است را بررسی کنیم.

اعداد میتوانند داستان کاملی از وجود انسانها روایت کنند. در کنیا، از هر هزار کودک ۴۳تایشان تولد پنجسالگی را نمیبینند. در مالزی، این اتفاق برای ۹ کودک میافتد. استون دراینباره سخنانی را از هانس رُسلینگ، متخصص سوئدی بهداشت عمومی، نقل میکند: «این شاخص میتواند درجۀ تب کلیِ جامعه را نشان دهد. چراکه بچهها بسیار آسیبپذیرند و عوامل زیادی میتواند آنها را به کشتن دهد». آن ۹۹۱ کودکی که در مالزی نمیمیرند درواقع آنهایی هستند که دربرابر خطر میکروبها، قحطی، خشونت و دسترسی محدود به خدمات بهداشتی محافظت شدهاند. همین یک عدد تصویر روشنی ارائه میدهد از تمام کارهایی که باید برای زندهماندن یک کودک انجام داد.

هارفورد در کتابش ما را با تعداد بیشتری از این نوع شاخصهای آماری آشنا میکند. او از ما میخواهد که روزنامهای را تصور کنیم که هر صد سال یک بار منتشر میشود: او ادعا میکند که اگر قرار بود یک شماره از آن امروز منتشر شود، یقیناً تیتر صفحۀ اول آن به کاهش چشمگیر مرگومیر کودکان در یک قرن اخیر اختصاص مییافت. او مینویسد: «مدرسهای را تصور کنید که قرار است صد کودک پنجساله را ثبتِنام کند، کودکانی که بهطور تصادفی در نقاط مختلف دنیا متولد شدهاند». در سال ۱۹۱۸، ۳۲ نفر از این کودکان تا قبل از روز اول مدرسه میمردند. تا سال ۲۰۱۸، این عدد به چهار نفر کاهش پیدا کرده بود. هارفورد معتقد است که این پیشرفت قابلِتوجهی است و هیچچیز بهجز آمار و ارقام نمیتواند تصویر واضحی از این پیشرفت در مقیاس کلان ترسیم کند.

این ابهامهای آماری حتی میتواند در خودِ موضوع تولد هم وجود داشته باشد. هارفورد داستانی را تعریف میکند از وجود اختلاف گیجکنندهای در آمار مرگومیر نوزادان. از قرار معلوم، این آمار در نواحی مرکزی انگلیس، موسوم به میدلندز، بهطرز چشمگیری بیشتر از لندن بود. آیا متخصصان زنان و زایمان در شهر لستر کارشان را بلد نبودند؟ مشکل دقیقاً این نبود. در بریتانیا، بارداریهایی که بعد از هفتۀ بیستوچهارم پایان یابد از نظر قانونی تولد محسوب میشوند؛ از سوی دیگر، بارداریهایی که قبل از هفتۀ دوازدهم به پایان برسد بهعنوان سقط در نظر گرفته میشوند.

در مورد بارداریهایی که جایی بین این دو زمان مشخص تمام میشوند -خواه در هفتۀ پانزدهم بارداری، خواه در هفتۀ بیستوسوم- واژهای که برای توصیف ازدستدادن جنین استفاده میشود بیش از همه برای والدین داغدار مهم است و بههرحال اصطلاحی در قانون برای آن پیشبینی نشده است. دکترهای میدلندز، طبق رسم خودشان، این موارد را بهعنوان مرگومیر کودک ثبت میکنند؛ دکترهای لندن، اما آن را سقطجنین اعلام میکنند. تفاوت در آمار برمیگشت به اینکه آنچه میشمردیم را چه مینامیدیم.

اعداد همیشه راست میگویند، مگر در مواردی که دروغ میگویند. حق با هارفورد است که میگوید آمار و ارقام میتوانند با شفافیت و دقتشان دنیا را روشن کنند. آمار و ارقام میتوانند علاجی باشند برای جایزالخطابودن ما انسانها. اما آنچه بهراحتی فراموش میشود این است که آمار و ارقام همچنین میتواند این خطاپذیری را تشدید کند. آنطور که استون به ما یادآوری میکند، «درست محاسبهکردن نیازمند فروتنی است تا بدانیم چه چیزهایی را نمیتوان یا نباید به حساب آورد».

اطلاعات کتابشناختی:

Stone, Deborah. Counting: How We Use Numbers to Decide What Matters. Liveright, ۲۰۲۰

Harford, Tim. The Data Detective: Ten Easy Rules to Make Sense of Statistics. Riverhead Books, ۲۰۲۱

پینوشتها:

• این مطلب را هانا فرای نوشته و در تاریخ ۲۹ مارس ۲۰۲۱ با عنوان «What Data Can't Do» در وبسایت نیویورکر منتشر شده است و برای نخستینبار با عنوان «اعداد همیشه راست میگویند، مگر وقتی که دروغ میگویند» در بیستمین شمارۀ فصلنامۀ ترجمان علوم انسانی با ترجمۀ بابک حافظی منتشر شده است. وب سایت ترجمان آن را در تاریخ ۲۰ آذر ۱۴۰۰با همان عنوان منتشر کرده است.

•• هانا فرای (Hannah Fry) استاد مرکز تحلیلهای پیشرفتۀ فضایی در یونیورسیتی کالج لندن است. جدیدترین کتاب او سلام دنیا (Hello World) نام دارد.

[۱]به ایهام موجود در کلمۀ حسابکردن (counting) توجه کنید. در اینجا هم به معنای «استفاده از اعداد و ارقام» است و هم به معنای «اعتمادکردن» و بهطور کلی اشاره دارد به اعتماد بیشازاندازه به آمار و ارقام [مترجم].

[۲]Goodhart's law: گودهارت معتقد بود شاخصها برای اندازهگیری وضعیت هستند و وقتی یک شاخصِ مفید به هدف تبدیل میشود، دیگر مفید نخواهد بود چراکه از آن به بعد صرفاً تلاش خواهد شد آن شاخص، به هر طریق ممکن، به مقدار تعیینشده برسد [مترجم].

[۳]numerical proxies

[۴]teach to the test: آموزشی که هدفش صرفاً موفقیت دانشآموز در آزمونها باشد [مترجم].

[۵]The Alignment Problem

[۶]یکی از مهمترین پرسشها و نگرانیها در حوزۀ هوش مصنوعی این است که چطور میتوان تضمین کرد که سیستمهای هوشمندی که انسان میسازد، که قابلیت یادگیری و خوداصلاحی دارند، هرگز در آینده برخلاف ارزشهای تعیینشده و اصول تعریفشده توسط انسانها رفتار نخواهند کرد. این موضوع را اصطلاحاً مسئلۀ همراستایی (همترازی) مینامند [مترجم].

[۷]The Hidden Half: How the World Conceals Its Secrets